Esta inteligencia artificial juega a StarCraft II mejor que el 99,8% de la gente

October 31, 2019 Noticias , TecnologíaEn el universo de este videojuego los seres humanos luchan contra alienígenas pero, fuera de él, el rival a batir son las máquinas. Un equipo de investigadores de Google ha desarrollado el algoritmo AlphaStar, capaz de derrotar a jugadores profesionales y alcanzar el máximo nivel en la clasificación.

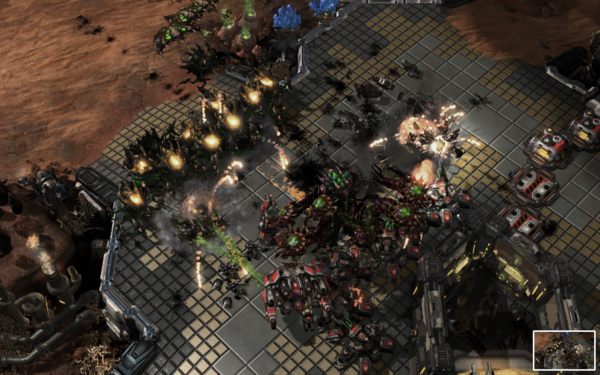

AlphaStar (en verde) con una combinación de poderosas unidades antiaéreas. / DeepMind

Humanos y alienígenas llevan enzarzados en una cruenta guerra por el control de la galaxia desde 1998, cuando la empresa Blizzard publicó el videojuego StarCraft, pionero de los hoy llamados esports y cuya segunda parte vio la luz en 2010. Fuera de la pantalla la lucha no tiene lugar contra insectoides, sino contra las máquinas: un algoritmo ha logrado colarse entre el 0,2 % de mejores jugadores del mundo. El avance se publica hoy en la revista Nature.

El algoritmo AlphaStar ha sido desarrollado por DeepMind, una empresa de inteligencia artificial adquirida por Google en 2014. En diciembre de 2018 el programa ya logró vencer a varios jugadores profesionales. Hasta entonces, los ordenadores solo eran capaces de ganar en StarCraft II haciendo ‘trampas’ con reglas simplificadas. Esto ha cambiado.

El algoritmo AlphaStar ha sido desarrollado por DeepMind, una empresa de inteligencia artificial adquirida por Google en 2014

“AlphaStar juega ahora con las mismas restricciones que un humano”, explica a Sinc el investigador de DeepMind, líder del proyecto y coautor del estudio, Oriol Vinyals. Esto incluye la visión del mundo “a través de una cámara” y “límites más estrictos” en la frecuencia de las acciones. Además, juega en el servidor oficial, Battle.net, con las mismas condiciones que los jugadores humanos, donde ha alcanzado el máximo nivel posible en la clasificación, Grandmaster.

El algoritmo ha mejorado desde que a finales del año pasado venciera por 5-0 a dos jugadores profesionales. Uno de ellos, Dario “TLO” Wünsch, colaboró con el equipo de investigadores para el trabajo. Ahora, AlphaStar puede jugar partidas uno contra uno encarnando a cada una de las tres razas de StarCraft II y también contra ellas, sin intervención humana. “Cada una de las facciones es una red neural diferente”, explica Vinyals.

Estrategia en tiempo real

StarCraft es uno de los videojuegos más importantes de la historia, tanto por ser uno de los más complejos en el género de la estrategia en tiempo real como por su relevancia para el mundo de los esports. También ha fascinado a los investigadores durante años por resistirse a sus esfuerzos por programar una inteligencia artificial capaz de derrotar a los seres humanos.

La principal diferencia con el ajedrez para los programadores es que no ves el otro lado del tablero, sino que debes mandar piezas a explorar lo que hace el oponente

Vinyals explica el atractivo que tiene el juego desde el punto de vista académico comparándolo con el ajedrez. “Lo principal es que no ves el otro lado del tablero, sino que debes mandar ‘piezas’ a explorar lo que hace el oponente”, explica.

Esta ‘ceguera’ inicial es uno de los motivos por lo que las máquinas han tenido problemas para superar a los humanos. El jugador empieza con “solo unas pocas piezas” y “debe decidir en cuáles invertir para contrarrestar las elecciones del oponente”, comenta Vinyals. También “cuándo expandirse para obtener más recursos que permitan comprar más piezas, con los riesgos asociados”.

A todo esto hay que sumar que cada pieza es más difícil de utilizar que un alfil o un peón. “En ajedrez, un caballo puede capturar otras piezas y tiene un patrón de movimiento concreto. En StarCraft, la unidad más básica puede hacer varias cosas, desde construir edificios a explorar, y debes hacerlas todas bien si quieres ser bueno”. Todo esto, recuerda el ingeniero, sucede en tiempo real.

AlphaStar gana un encuentro final. / DeepMind

Más que videojuegos

El interés de Vinyals por esta saga de videojuegos viene de lejos. Cuando StarCraft llegó al mercado en 1998, el ingeniero que hoy trabaja para Google DeepMind tenía unos 15 años. Pronto se vio atrapado por la creación de Blizzard y, hasta 2001, se mantuvo entre los diez mejores jugadores de España.

Pero el estudio publicado en Nature va más allá del mundo de los videojuegos. Según los investigadores, el algoritmo se podría adaptar para solucionar otro tipo de problemas complejos que no impliquen conquistar razas alienígenas ficticias.

“Estoy muy interesado en aplicar las técnicas de AlphaStar en áreas que he investigado anteriormente como el lenguaje y otros datos con una estructura jerárquica similares a las acciones que se requieren para jugar a StarCraft”, comenta Vinyals. ¿Por ejemplo? “En Spiral usamos el mismo agente pero, en vez de jugar, usa un programa como Paint para pintar imágenes”.

Ajedrez, go y redes neuronales

En 1997 el supercomputador Deep Blue fue el primero en derrotar a un campeón mundial de ajedrez, Gary Kaspárov, ayudado por un fallo informático. Desde hace unos 15 años el mejor ajedrecista del mundo es una máquina, según contaba a Sinc el periodista especializado en este deporte Leontxo García.

El algoritmo se podría adaptar para solucionar otro tipo de problemas complejos que no impliquen conquistar razas alienígenas ficticias

El interés de los investigadores en el campo de la inteligencia artificial se movió entonces a otros juegos más complejos, como el Go japonés, un reto mayor debido al número de posiciones existentes. En 2016 AlphaGo, otro programa de Google DeepMind, derrotaba por primera vez a un humano al vencer al campeón europeo. Desde entonces, la empresa se ha interesado por otros juegos como Hanabi.

Vinyals explica por qué unos juegos se resisten más que otros y por qué han tenido que pasar más de 20 años entre Deep Blue y AlphaStar. “Los algoritmos clásicos de búsqueda [capaces de localizar el mejor movimiento en una base de datos] se han usado para juegos como ajedrez, pero para que funcionen bien el ‘espacio de búsqueda’ tiene que ser simple o requeriría demasiado tiempo calcular los movimientos óptimos”.

Equipo de DeepMind en una demo.

El investigador asegura que en 2000 los ordenadores ya eran lo bastante potentes como para jugar al ajedrez a nivel profesional, pero el Go hubiera requerido “quizás hasta 2025”. ¿Cómo es posible que DeepMind se adelantara casi una década? La respuesta está en las redes neuronales que utilizan algoritmos como AlphaStar.

“[Las redes neuronales] permiten analizar una situación de juego mediante aprendizaje automático, en lugar de con reglas específicas, y ver qué acción es mejor”, dice Vinyals. “A partir de esto empezamos a desarrollar sistemas que juegan contra sí mismos, mejorando la red neuronal para dar lugar a AlphaGo y AlphaStar”.

AlphaStar ha llegado a nivel Grandmaster, pero todavía no lo sabe todo

El resultado sería “impensable” con algoritmos de búsqueda. “En ajedrez hay unas 30 opciones por cada movimiento y unos 50 movimientos en total”, comenta el ingeniero. “En Go, 250 opciones por movimiento y hasta 200 movimientos en total”. En StarCraft, “existen 1026 opciones por cada ‘movimiento’ y miles de movimientos por juego”.

¿Significa todo esto que el mejor jugador de StarCraft II del mundo es también un ordenador? AlphaStar ha llegado a nivel Grandmaster, pero todavía no lo sabe todo. “Es un hito muy importante y muy por encima de lo que se había logrado, con un nivel de juego por encima del 99,8 % de los jugadores, pero también perdió algunas partidas”.

En otras palabras, el programa todavía no está por encima de ‘todos’ los profesionales. Vinyals confía en que su trabajo, accesible en internet, invite a otros investigadores a desarrollar más técnicas de inteligencia artificial: “Espero que algún día el 99,8 % se convierta en el 100 %”.